wissen.de Artikel

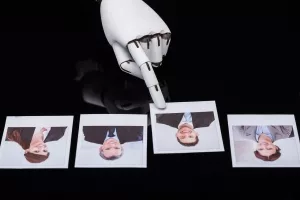

Wie objektiv ist die künstliche Intelligenz?

D

Wie lernen künstliche Intelligenzen?

Möglich wird all dies dank der Fähigkeit der KI-Systeme, in kurzer Zeit enorme Datenmengen auszuwerten und dabei Muster und Zusammenhänge zu erkennen. So lernt der Algorithmus beispielsweise anhand unzähliger Fotos von Haustieren mit entsprechender Benennung, wie Hunde oder Katzen aussehen. Nach einer Zeit des Trainings kann das System dann auch ganz neue Fotos der richtigen Tierart zuordnen. Es hat selbstständig die relevanten Unterscheidungsmerkmale gelernt.

Viele andere KI-Systeme nutzen Texte als Trainingsgrundlage. Sie werten aus, in welchem Kontext ein Wort steht und lernen darüber seine semantische Bedeutung und auch Verknüpfungen mit ähnlichen Wörtern oder Synonymen. Erst durch diese Fähigkeit kann eine künstliche Intelligenz beispielweise medinische Daten und Krankenakten auswerten und so Medizinern bei der Diagnosestellung helfen. In den USA nutzen Gerichte sogar schon Algorithmen, um die Wahrscheinlichkeit für einen Rückfall bei angeklagten Straftätern einzuschätzen.

Das Problem jedoch: Je weiter die künstliche Intelligenz in verschiedene Bereiche unserer Gesellschaft vordringt, desto größer sind auch die möglichen Konsequenzen ihrer Entscheidungen. Gleichzeitig werden die Zusammenhänge und Entscheidungsgrundlagen immer komplexer, so dass sie sich von uns Menschen nur noch schwer nachvollziehen lassen. Im Extremfall bedeutet dies, dass eine Kontrolle der KI-Entscheidungen nur noch eingeschränkt möglich ist.

Subtile Verzerrungen

Das wirft die Frage auf, wie objektiv und "richtig" eine künstliche Intelligenz ihre Entscheidungen fällt? Gängiger Annahme nach sollen lernfähige Algorithmen bessere, schnellere und vor allem gerechtere Entscheidungen treffen können als wir Menschen. Denn wo wir vorurteilsbelastet und voreingenommen sein können, entscheidet die KI absolut rational und unparteiisch – oder doch nicht?

Gleich mehrere Studien haben die Unvoreingenommenheit der KI inzwischen als Irrtum entlarvt. Denn die meisten KI-Systeme lernen aus menschengemachten Quellen – Texten, Bildern oder von uns zusammengestellten Datenbanken. Und wenn dieses Trainingsmaterial implizite Vorurteile oder verzerrte Abbilder der Wirklichkeit enthält, lernt das Maschinenhirn sie gleich mit, wie schon 2017 ein Assoziationstest ergab. Dabei absolvierte eine zuvor mit Texten aus dem Internet trainierte KI einem psychologischen Test, der unbewusste Stereotype entlarven kann.

Und tatsächlich: Ähnlich wie viele Menschen tappte auch das Maschinenhirn in die Falle. Es assoziierte zum Beispiel männliche, in afro-amerikanischen Kreisen häufige Vornamen mit „unangenehm“, „typisch weiße“ dagegen eher mit positiven Attributen. Frauen assoziierte das Programm eher mit Kunst und „Helfer“, Männer wurden dagegen häufiger mit Führungsattributen und Mathematik verknüpft.

Um solche voreingenommenen Entscheidungen der KI-Systeme zu verhindern, muss daher besonders darauf geachtet werden, dass die Datengrundlage nicht verzerrt ist. Das Problem jedoch: Meist wird die subtile Verzerrung der Trainings-Daten erst im Nachhinein klar – wenn die KI bereits Anzeichen voreingenommener Einordnungen zeigt.

Vorurteile auch ohne menschlichen Input

Und es gibt noch ein Problem: Wissenschaftler haben Indizien dafür gefunden, dass künstliche Intelligenzen sogar ohne vorbelasteten Input von uns Menschen Vorurteile entwickeln können. Das zeigte ein Experiment, in dem 100 smarte Bots in einem Geben-und-Nehmen-Spiel miteinander interagierten – ohne Training durch menschengemachte Daten.

Das überraschende Ergebnis: Im Laufe des Experiments tendierten die Bots immer stärker dazu,

fremde Gruppen auszuschließen und Spenden nur an eigenen Teammitglieder zu vergeben. Sie entwickelten damit immer stärkere Vorurteile gegenüber "den Anderen". Der Grund dafür: Die smarten Bots passten ihre Spielstrategie an, indem sie das Verhalten der Mitspielenden kopierten, die am meisten Geld einsammelten und am erfolgreichsten waren. Auf diese Weise entstanden Gruppen von Akteuren, die sich ähnlich verhielten und konsequent nicht zugehörige Spielteilnehmer ausschlossen.

Damit scheint klar: Auch Maschinenhirne sind keineswegs so objektiv, unvoreingenommen und sozial wie lange gedacht. Sollen sie künftig wichtige und potenziell folgenreiche Entscheidungen treffen, muss man dies berücksichtigen – und wo möglich gegensteuern.