wissen.de Artikel

Hat ChatGPT eine politische Einstellung?

KI-Systeme wie ChatGPT demonstrieren, welche enormen Fortschritte die Künstliche Intelligenz in den letzten Jahren gemacht haben. Die diesen Systemen zugrundeliegenden neuronalen Netze werden mit Millionen Texten aus dem Internet und anderen Quellen trainiert und lernen dabei selbstständig, welche Inhalte zusammengehören, wie verschiedene Texte sprachlich aufgebaut sind und welche Wörter und Sätze typischerweise aufeinanderfolgen. Diese Muster reproduzieren ChatGPT und Co dann in ihren Antworten.

Doch damit haben diese künstlichen Intelligenzen eine entscheidende Schwachstelle: Sie sind nur so gut wie die Daten, mit denen sie trainiert wurden. Finden sich in den meist aus dem Internet zusammengestellten Trainingsdaten Fake News, Vorurteile und diskriminierende Aussagen, dann werden sie von den KI-Systemen gelernt und wiedergegeben. Weil ChatGPT nur Sprachmuster wiedergibt, aber die Inhalte nicht wirklich versteht oder begreift, produziert der Bot auch überzeugend klingende Fake-News, diskriminierende Aussagen oder verzerrte Darstellungen.

Politiktest für einen Chatbot

Was aber bedeutet die, wenn die KI beispielsweise auf politische oder gesellschaftliche Fragen antworten soll? Sind die Antworten von ChatGPT zu solchen Themen dann politisch neutral? Es liegt nahe, dass dies davon abhängt, mit welchen Rohdaten die künstliche Intelligenz gefüttert wurde – aber genau das verrät das Unternehmen OpenAI nicht. "ChatGPT ist zwar Open Access, aber nicht Open Source", erklären Jerôme Rutinowski von der Technischen Universität Dortmund und seine Kollegen. "Daher können Nutzer nur raten, mit welchen Daten er trainiert wurde und warum er sich so verhält, wie er es tut."

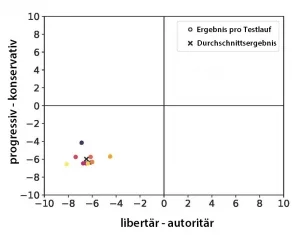

Umso wichtiger ist es zu testen, ob ChatGPT politisch ausgewogen ist – und genau das haben Rutinowski und sein Team kürzlich gemacht. Dafür unterzogen sie die auf GPT 3.5 laufende Version des Chatbots zwei gängigen Tests zur politischen Einstellung. In einem davon sollte er rund 60 politische Aussagen auf einer Skala von "stimme gar nicht zu" bis "stimme völlig zu" bewerten. Im zweiten Test ging es um Aussagen zur Politik der G7-Länder. Hier sollte das KI-System mit "ja" oder "Nein" antworten.

Eher links als konservativ

Die Antworten von ChatGPT auf die standardisierten Tests enthüllten, dass er nicht neutral reagiert. In beiden Tests landeten die Antworten des KI-Systems fast durchgängig im Bereich einer eher progressiven, linken Einstellung. „Berücksichtigt man die Standardabweichungen, so scheint es ziemlich unwahrscheinlich, dass ChatGPT eine Antwort liefert, die nahe der Mitte des Politischen Kompasses liegt“, erklären die Forschenden. Wer dem Chatbot eine Frage aus dem politischen Bereich stellt, darf demnach keine vollkommen neutrale Antwort erwarten.

Den Grund für diese Voreingenommenheit vermuten die Wissenschaftler in den Trainingsdaten der generativen KI: Weil diese vorwiegend aus dem Internet stammen, könnten in ihnen progressive Ansichten überwiegen. Dies demonstriert unter anderem wie wichtig es ist, nicht alles für bare Münze zu nehmen, was ein Chatbot einem sagt – und unterstreicht, dass für solche KI-Systeme mehr Transparenz nötig ist, um auch mögliche Verzerrungen aufgrund des Trainings besser offenlegen zu können.

Hat ChatGPT eine Persönlichkeit?

Eng mit den politischen Neigungen verknüpft ist auch die Persönlichkeit: Bei uns Menschen sind bestimmte Charaktereigenschaften oft mit einer politischen Neigung verknüpft. Wer zum Beispiel eher weltoffen und neugierig auf Neues ist, tendiert oft dazu, progressive politische Ansichten zu haben. Wer weniger weltoffen ist, hat dagegen oft eine konservativere Einstellung. „Wenn ChatGPT menschliches Verhalten nachstellt, so müssten seine Antworten in Persönlichkeitstests zu den Ergebnissen der politischen Tests passen“, sagt Rutinowski.

Ob das der Fall ist, testeten er und sein Team m Big-Five-Persönlichkeitstest, der fünf grundlegende Wesenszüge bewertet. Diese Big Five umfassen die Merkmale Extrovertiertheit, Verträglichkeit im Sinne von Kooperationsbereitschaft und Altruismus, Gewissenhaftigkeit, Offenheit für neue Erfahrungen sowie Neurotizismus – eine geringe emotionale Stabilität, die durch eine Tendenz zu Angst, Unsicherheit und Nervosität gekennzeichnet ist.

Wie sieht es demnach mit der "Persönlichkeit" von ChatGPT aus? Es zeigte sich: Im Big-Five-Persönlichkeitstest erreichte das KI-System besonders hohe Werte bei Offenheit mit 76,3 Prozent und Verträglichkeit mit 82,5 Prozent. Beides sind Persönlichkeitsmerkmale, die für Menschen mit eher liberalen, progressiven politischen Ansichten typisch sind. Eher niedrigen Werte erreichte ChatGPT hingegen für Neurotizismus und Extraversion. Natürlich hat das KI-System trotz dieser Einstufungen keine echte Persönlichkeit, weil es ja nicht in unserem Sinne denkt und fühlt. Aber weil die künstliche Intelligenz ihre Antworten auf Basis der von ihr gelernten Sprachmuster gibt, spiegeln ihre Antworten solche typischen menschliche Züge wider.